Avaliação de modelos

Você já se perguntou como saber se um modelo de machine learning está realmente funcionando? É aí que entra a avaliação de modelos!

| Avaliação de Modelos | |

|---|---|

|

A avaliação de modelos de machine learning é como um detetive investigando um caso |

O nosso modelo é um herói ou um impostor?

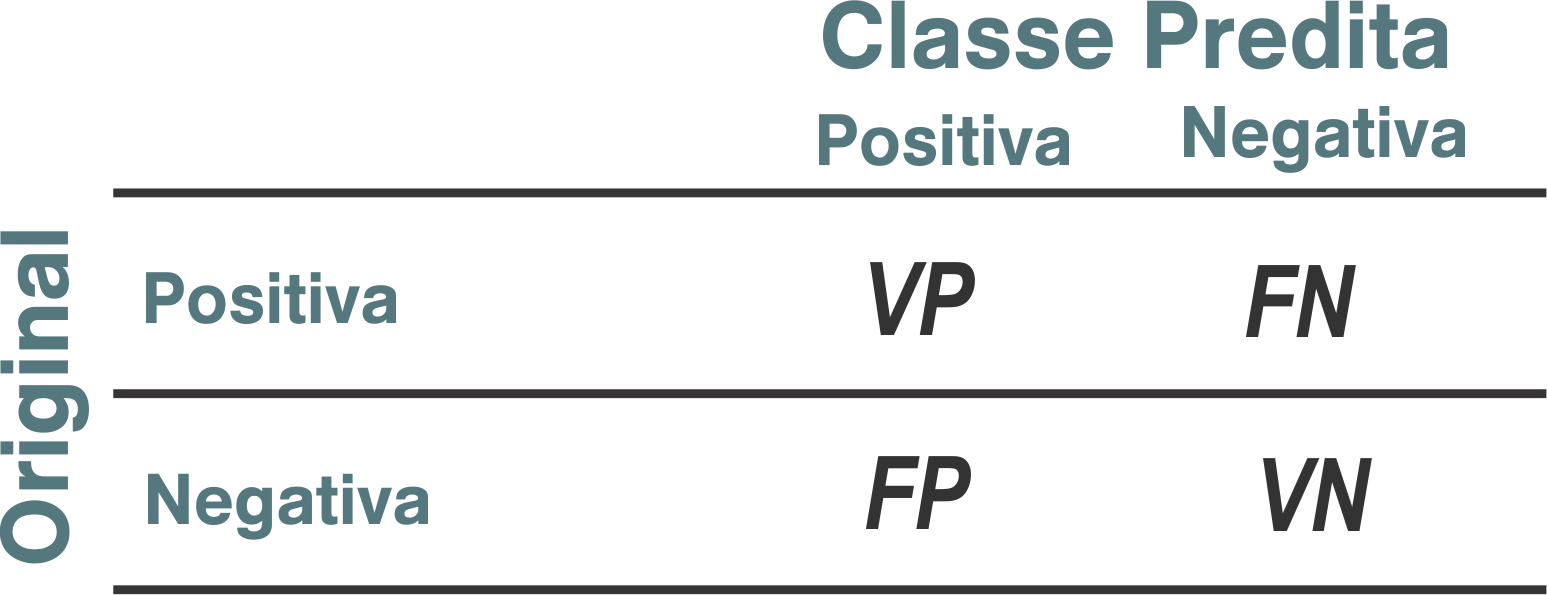

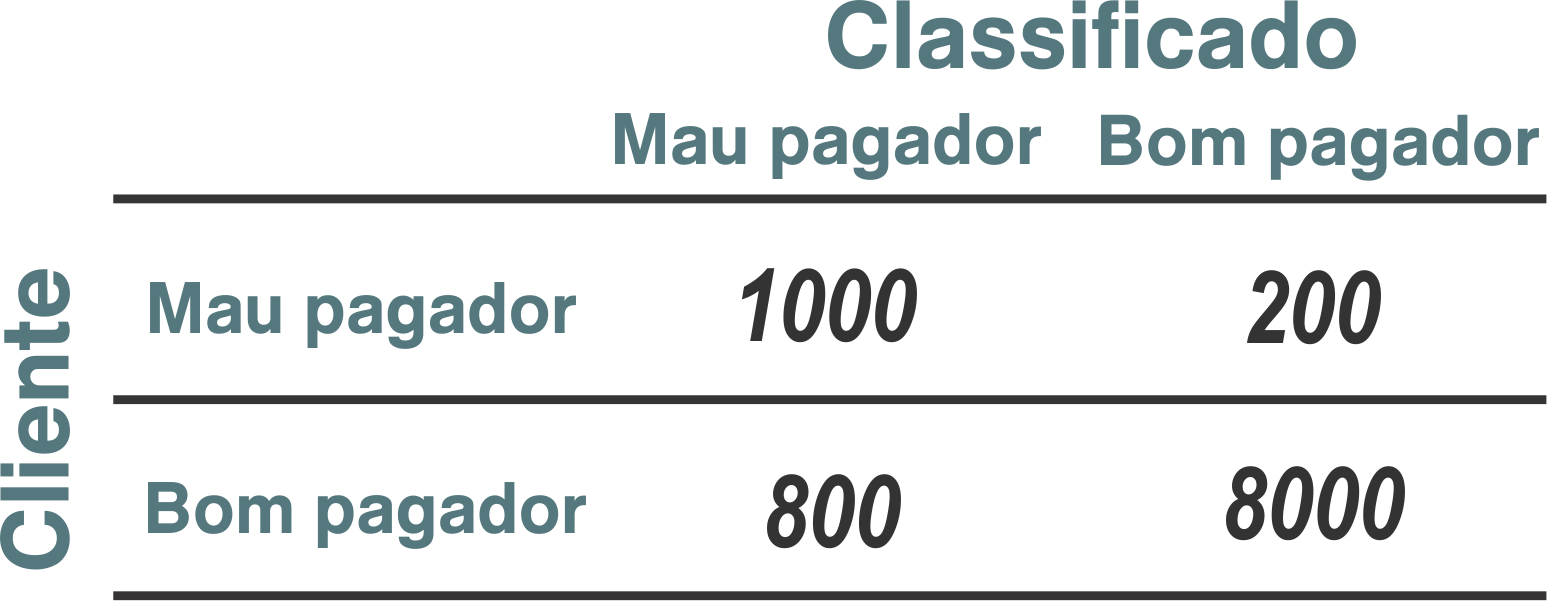

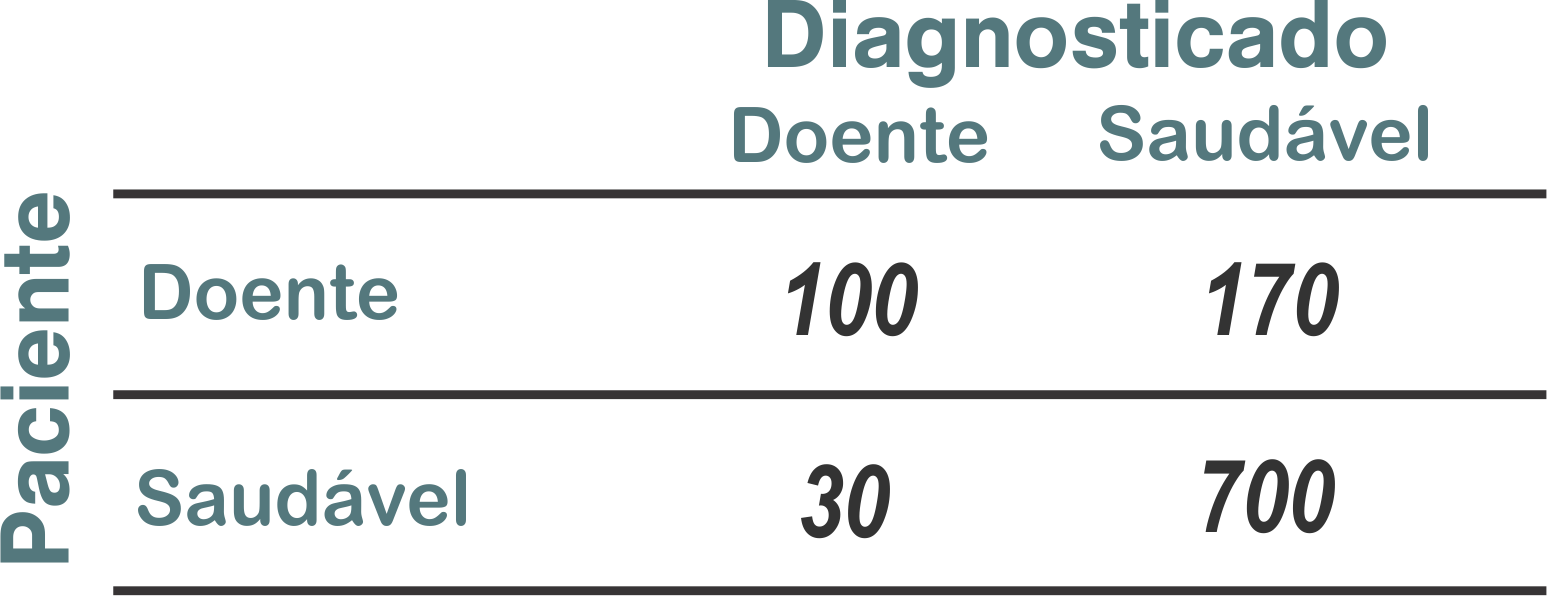

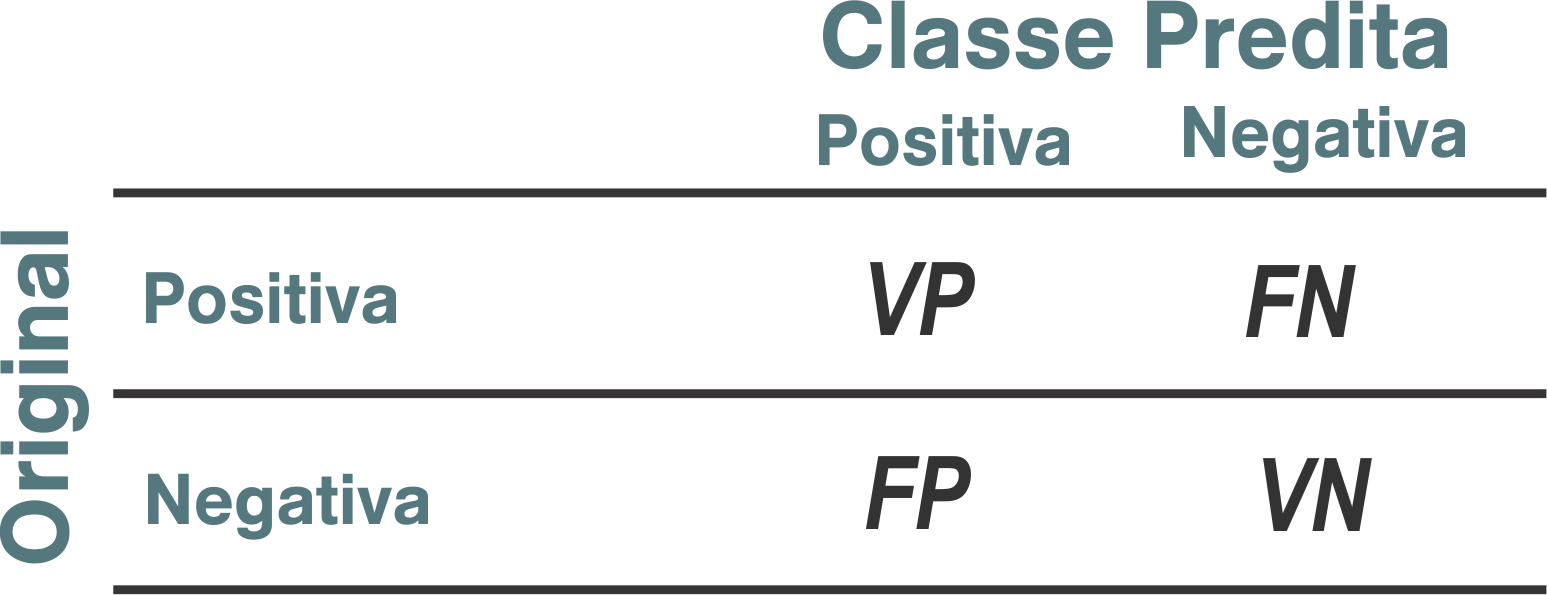

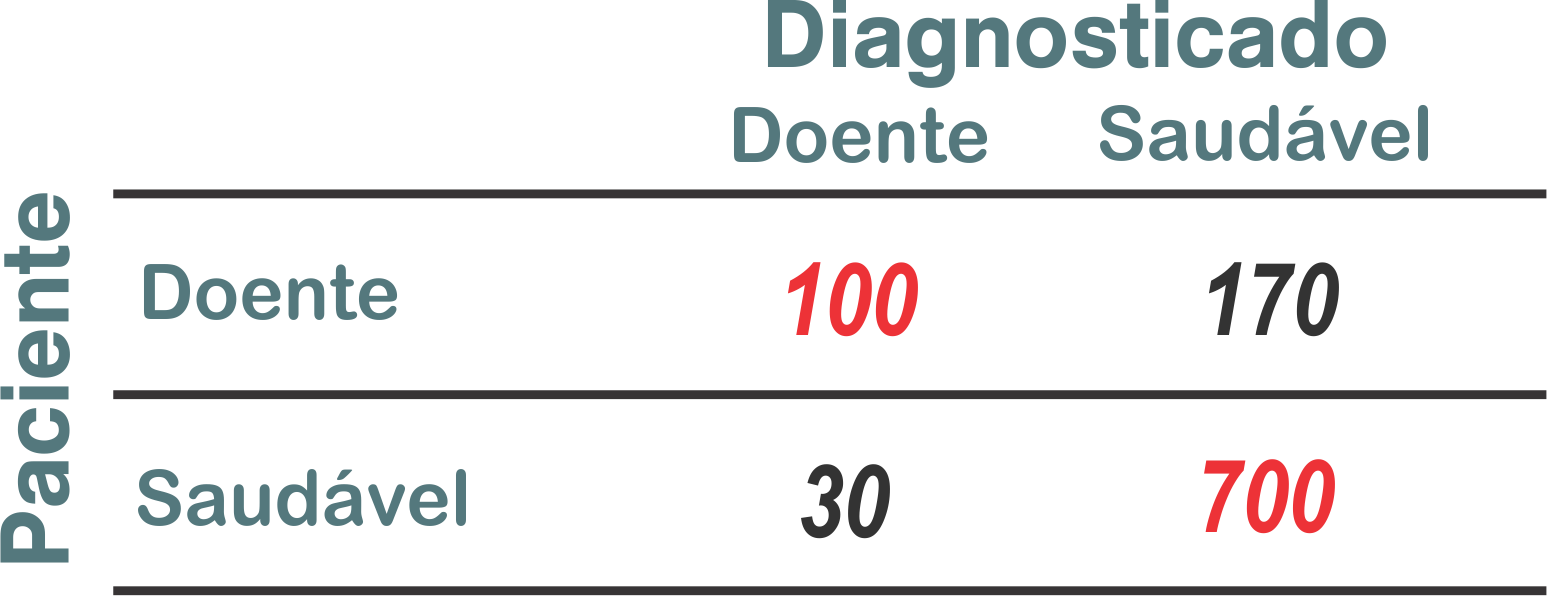

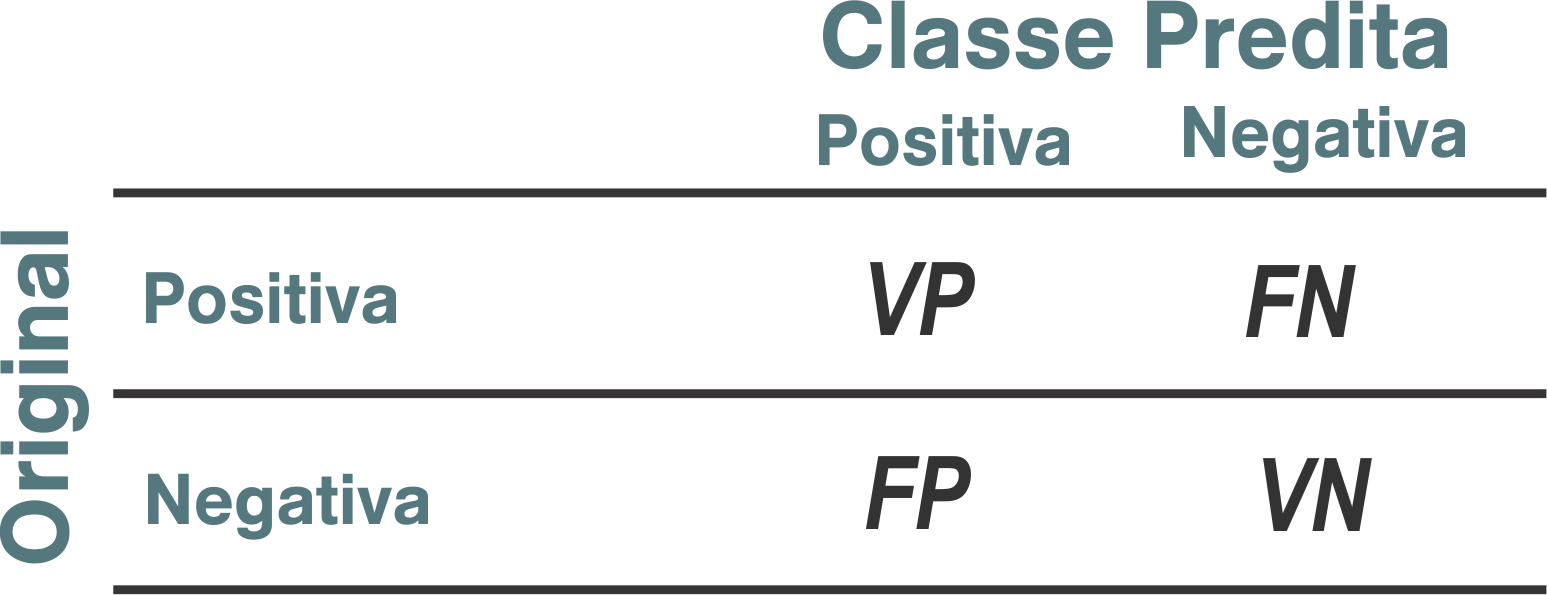

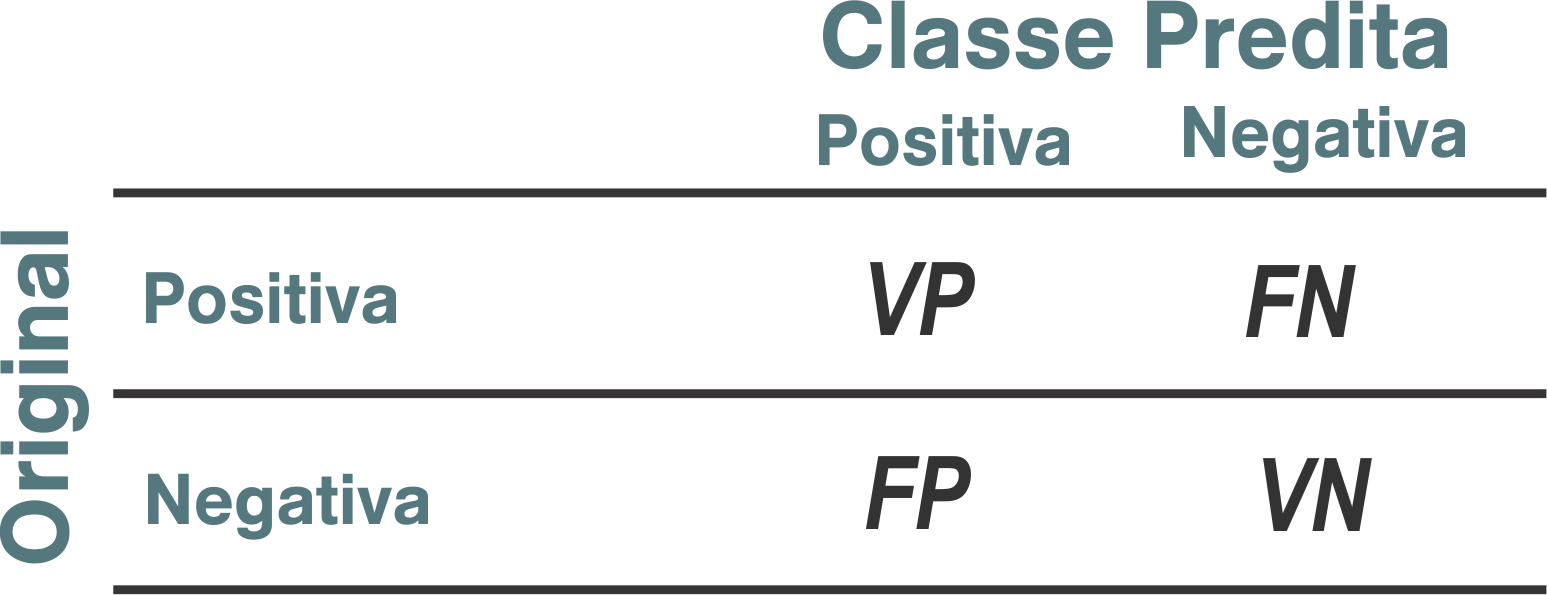

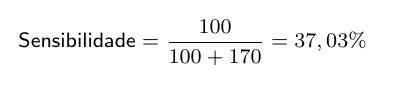

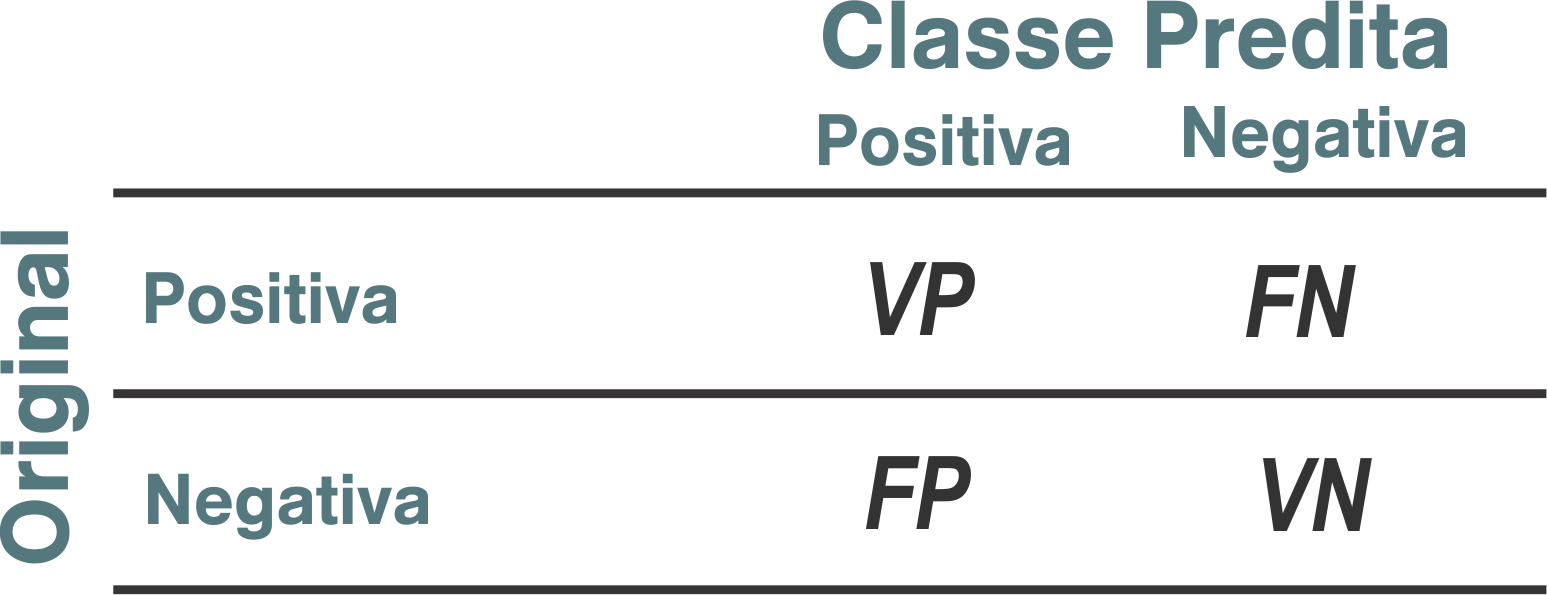

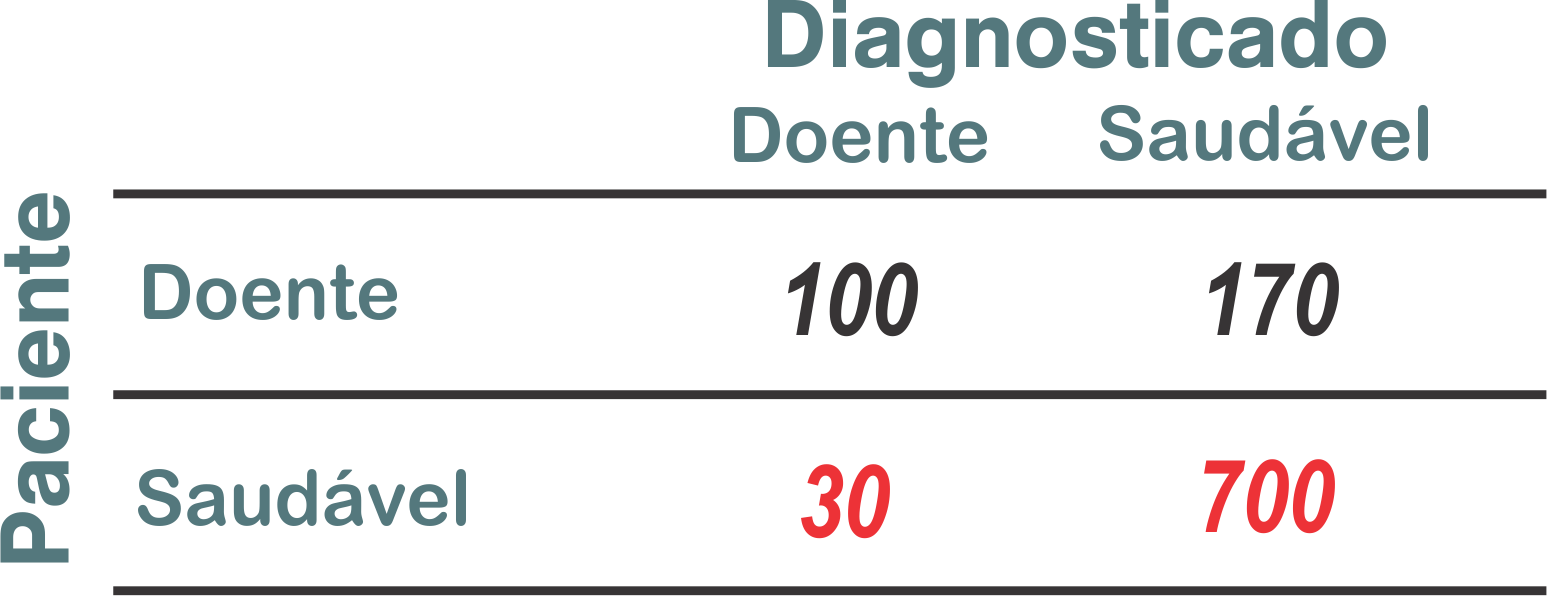

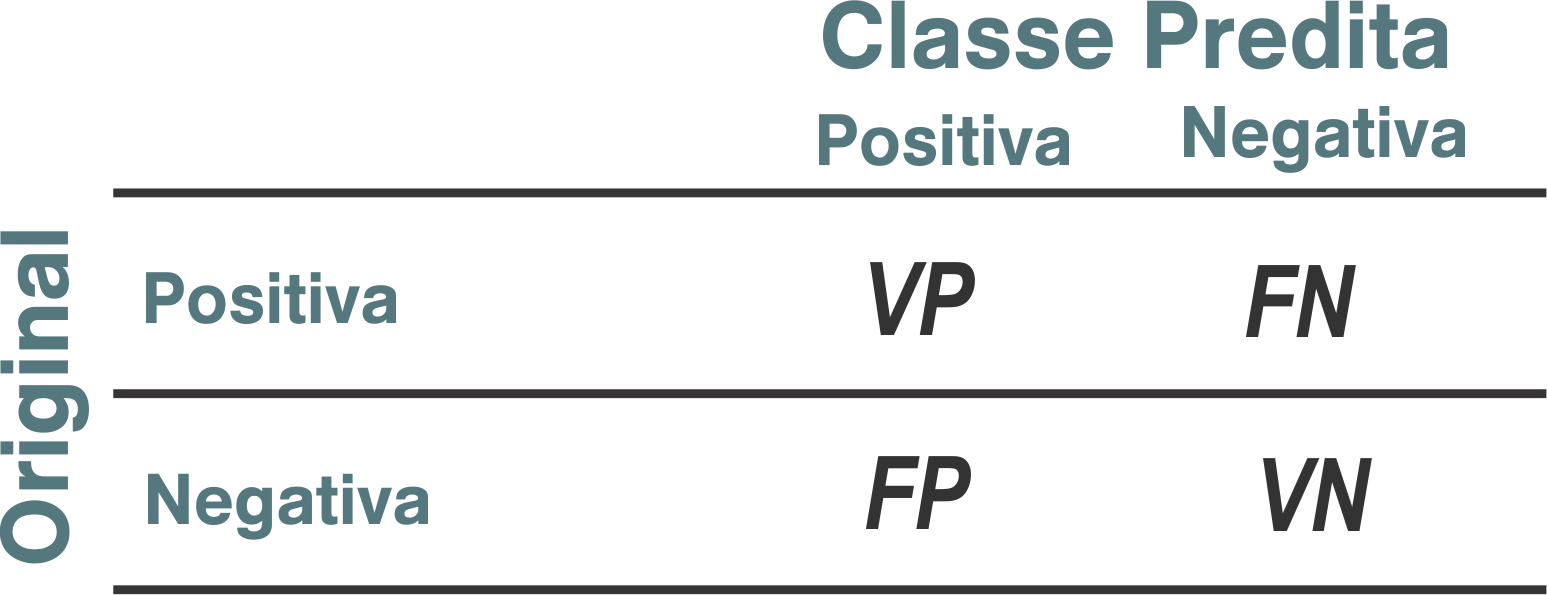

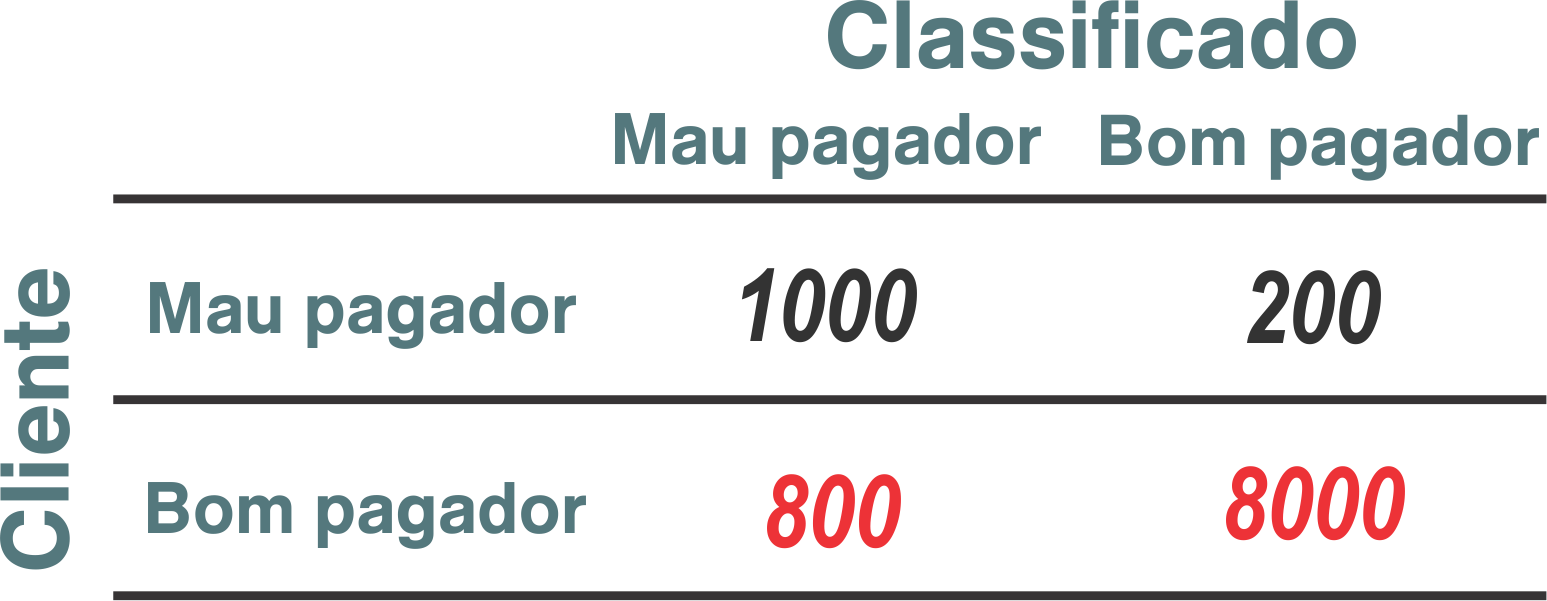

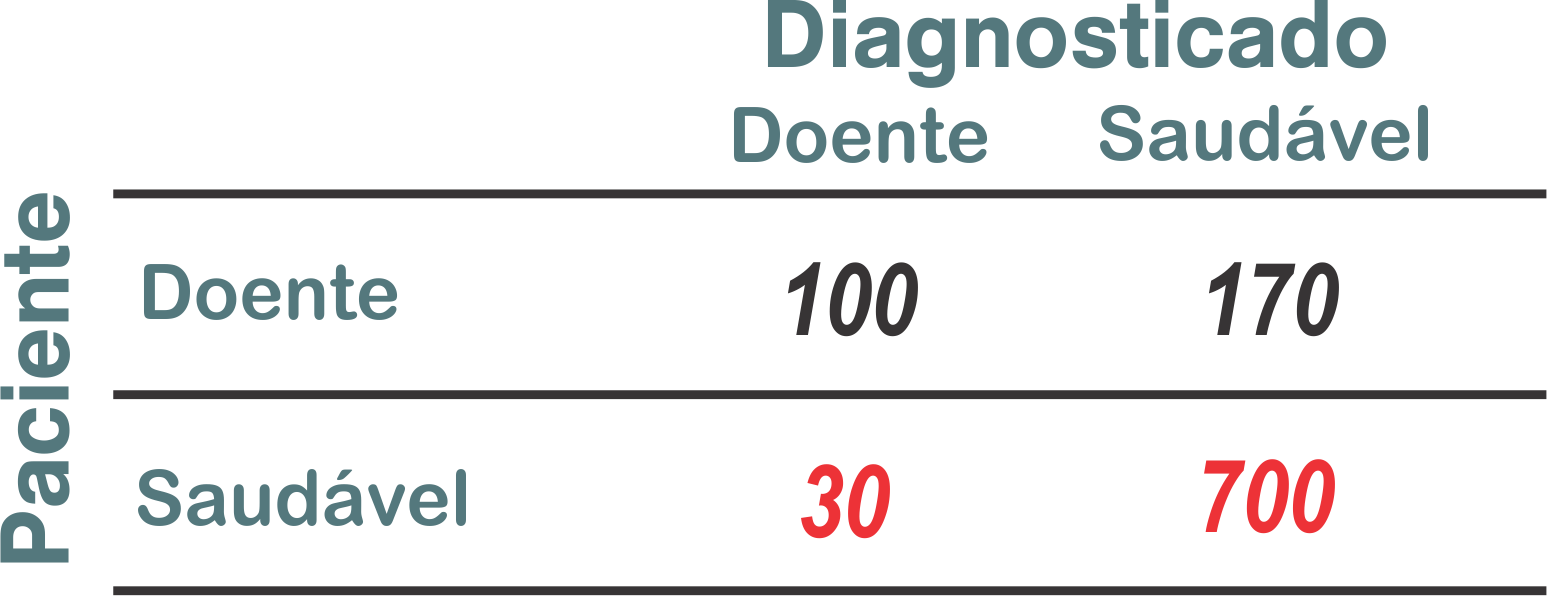

Matriz de confusão

Permite a visualização do desempenho do algoritmo

- VP (Verdadeiro Positivo): objeto da classe positiva classificado como positivo

- VN (Verdadeiro Negativo): objeto da classe negativa classificado como negativo

- FP (Falso Positivo): objeto da classe negativa classificado como positivo. Também conhecido como alarme falso ou Erro tipo 1

- FN (Falso Negativo): objeto da classe positiva classificado como negativo. É também conhecido como Erro Tipo 2

| Exemplos | |

|---|---|

|

|

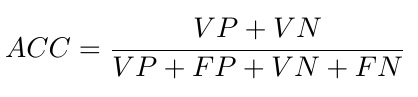

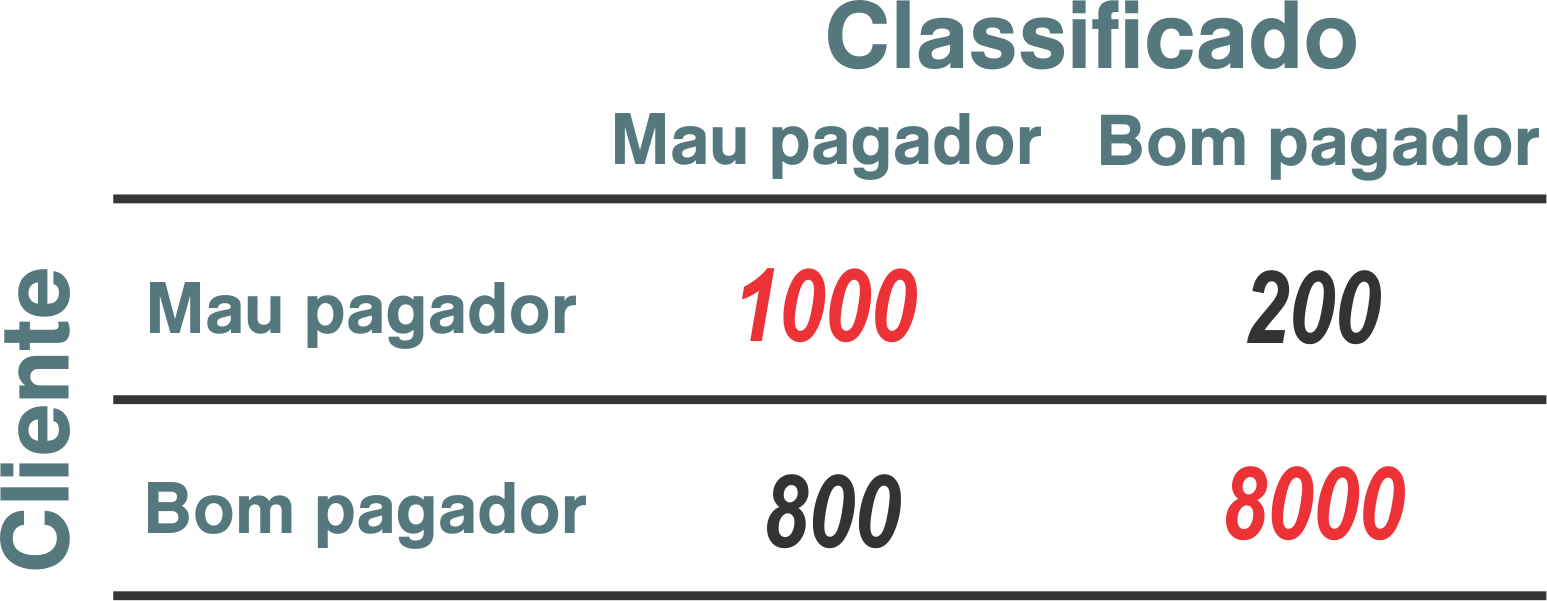

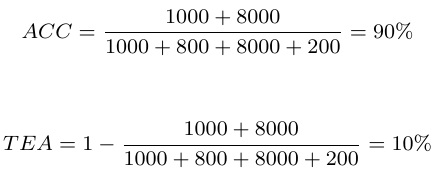

| Acurácia | |

|---|---|

|

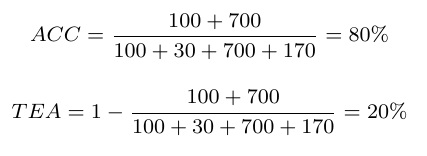

Mede a proporção de previsões corretas do modelo em relação ao total de previsões feitas. |

É como sua nota em uma prova!

| Acurácia | |

|---|---|

|

|

A Taxa de Erro Aparente do classificador é dada por

$$TEA = 1 - ACC$$| Exemplos | |

|---|---|

|

|

|

|

Mas será que a acurácia é suficiente para avaliar nossos modelos de forma precisa?

Às vezes, uma única métrica não é capaz de nos contar toda a história.

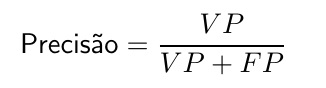

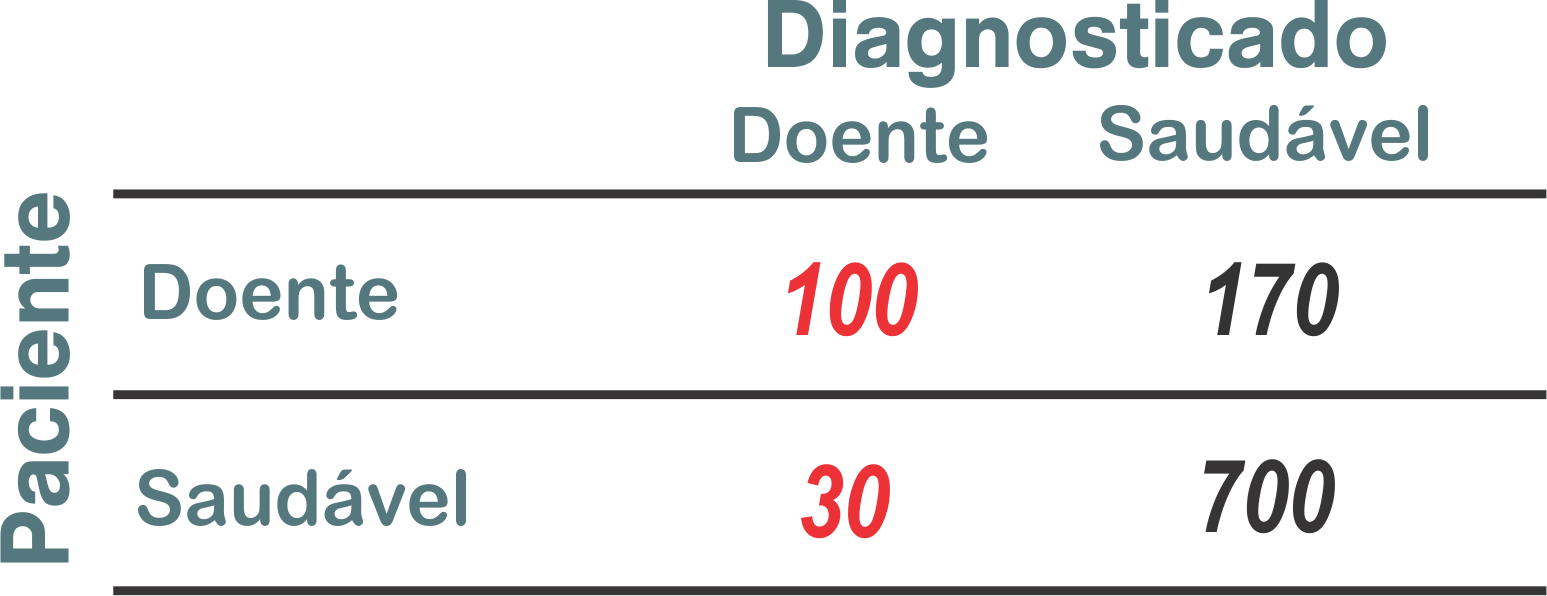

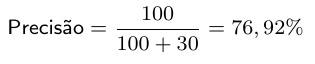

| Precisão | |

|---|---|

|

Ela nos diz quantas das previsões positivas foram realmente corretas. |

| Precisão | |

|---|---|

|

|

Porcentagem de verdadeiros positivos dentre todos os objetos classificados como positivos

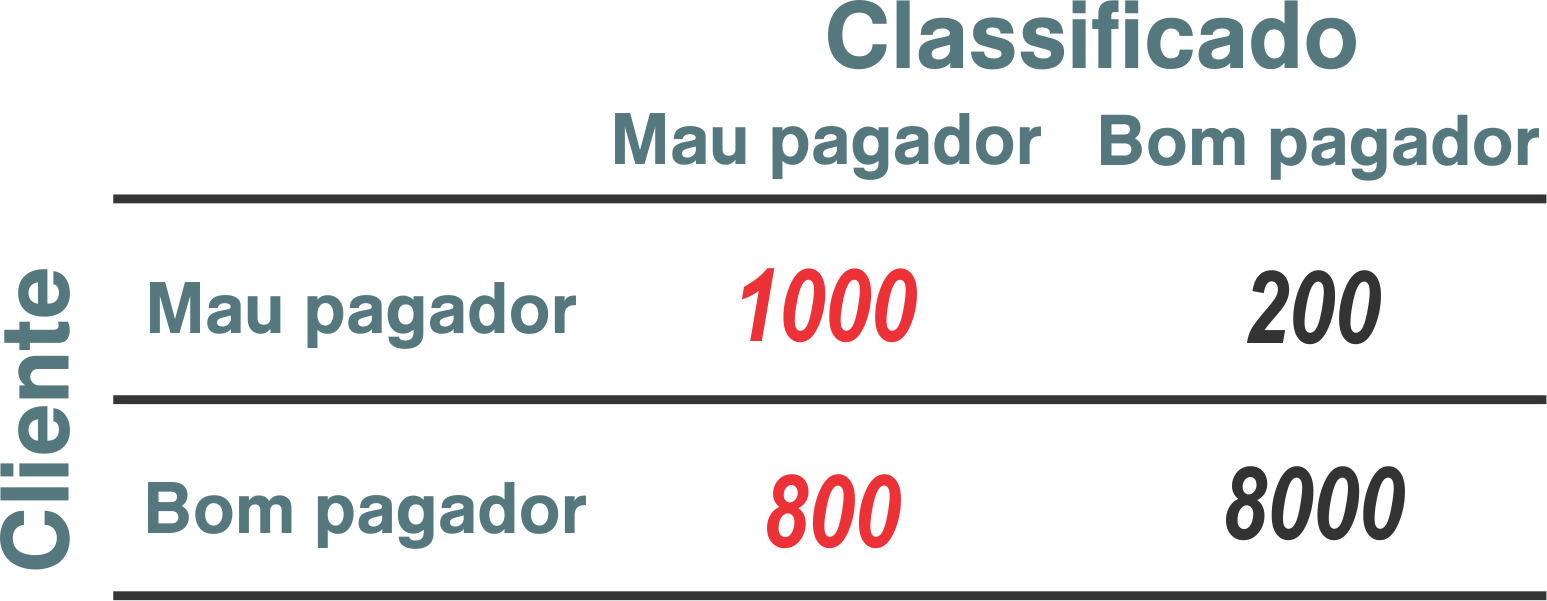

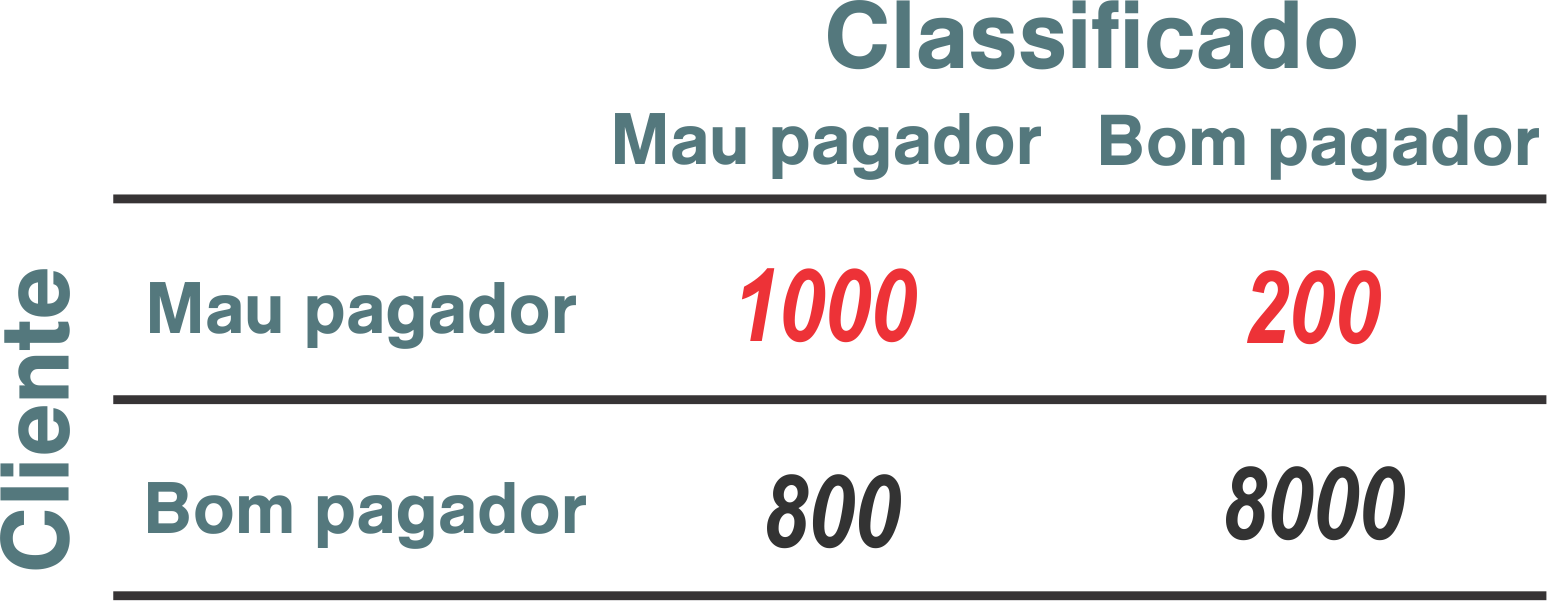

| Exemplos | |

|---|---|

|

|

|

|

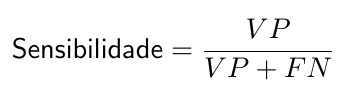

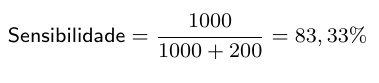

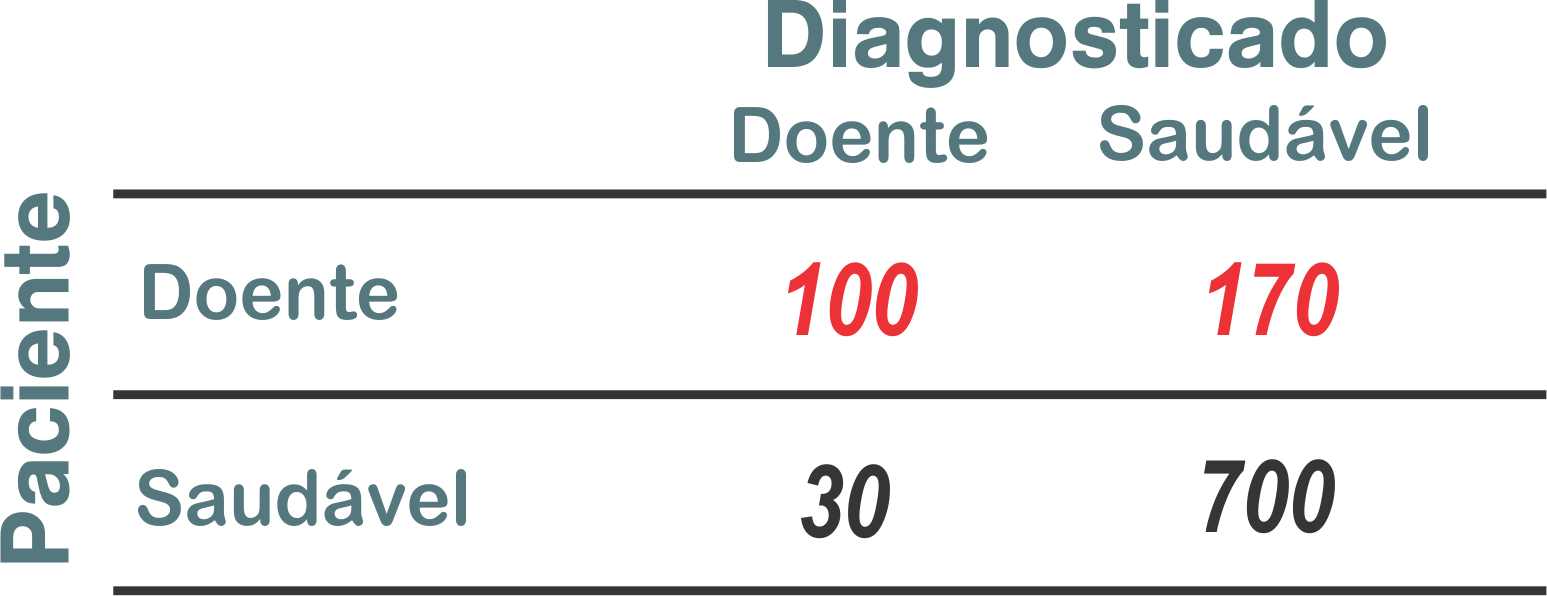

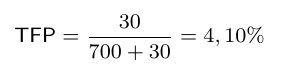

| Sensibilidade | |

|---|---|

|

Mede a proporção de casos positivos reais que foram encontrados pelo modelo |

| Sensibilidade | |

|---|---|

|

|

Também conhecida por Recall ou Taxa de Verdadeiros Positivos (TVP)

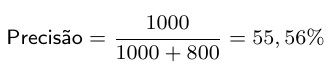

| Exemplos | |

|---|---|

|

|

|

|

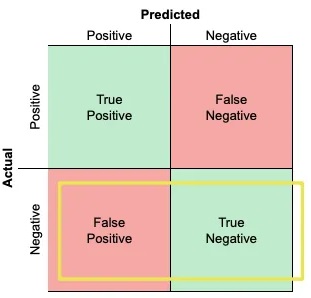

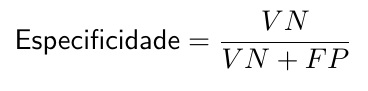

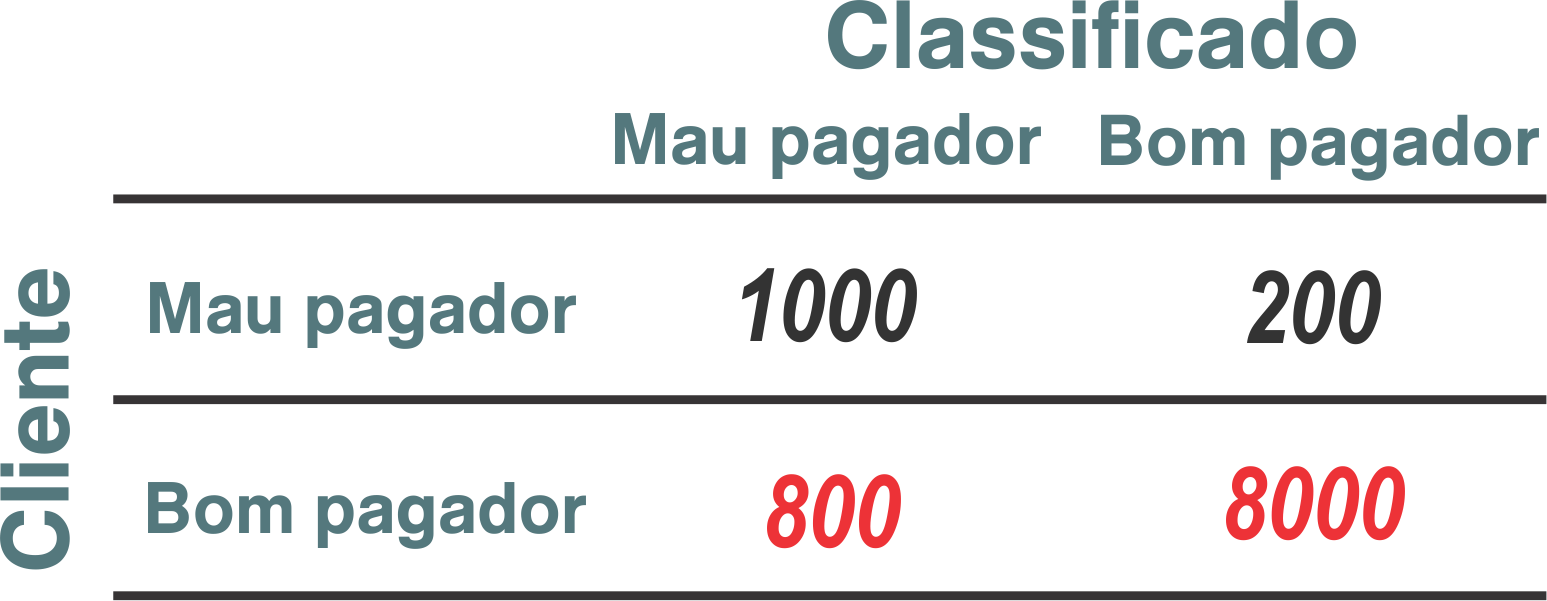

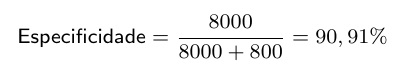

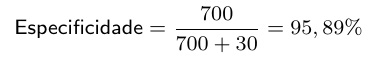

| Especificidade | |

|---|---|

|

Ajuda a identificar a capacidade do modelo em reconhecer corretamente as amostras negativas |

| Especificidade | |

|---|---|

|

|

Também conhecida por Taxa de Verdadeiros Negativos (TVN)

| Exemplos | |

|---|---|

|

|

|

|

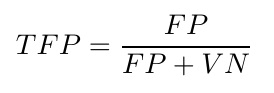

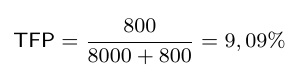

| Taxa de Falso Positivo | |

|---|---|

|

Ela mede a proporção de amostras negativas classificadas como positivas pelo modelo |

| Especificidade | |

|---|---|

|

|

| Exemplos | |

|---|---|

|

|

|

|

| F1 - Score | |

|---|---|

|

Ele leva em consideração tanto precisão quanto a sensibilidade, dando uma medida balanceada do desempenho do modelo. |

O F1-score é como um equilibrista em uma corda bamba.

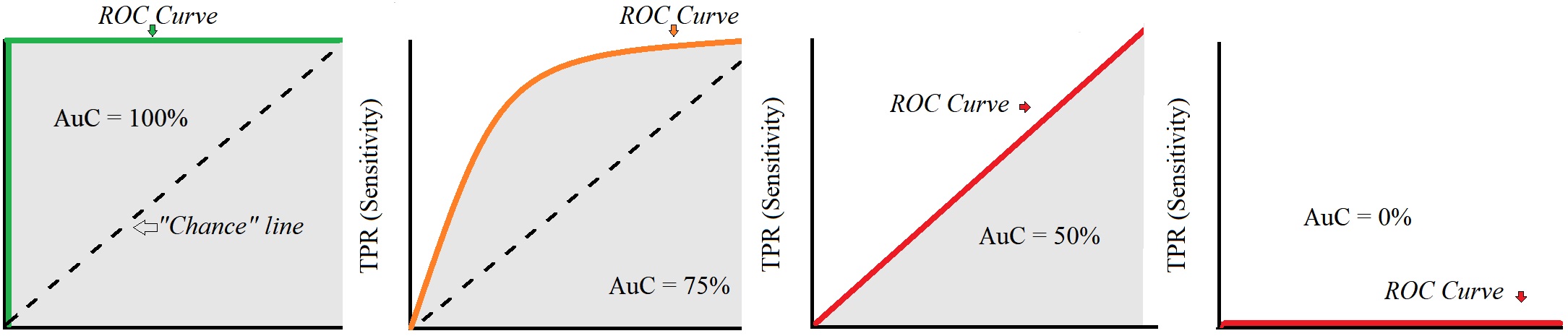

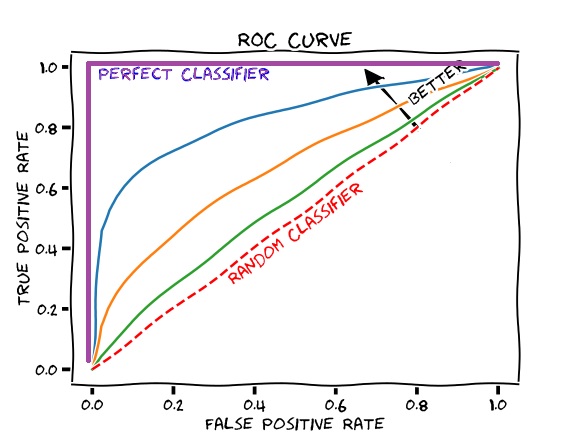

Curva ROC

A Curva ROC é como um mapa que nos guia pela sensibilidade e pelos falsos positivos do modelo em diferentes configurações.

Ela nos mostra o quão bem nosso modelo pode distinguir entre as classes.

Representa o número de vezes que o classificador acertou a predição contra o número de vezes que o classificador errou a predição

A área sob a curva ROC, conhecida como AUC-ROC, é uma métrica comumente utilizada para avaliar o desempenho global do modelo.

Quanto maior a AUC-ROC, melhor é o desempenho do modelo em discriminar corretamente as classes.